Melanjutkan catatan sebelumnya, saat ini kondisi existing ceph cluster memiliki 3 buah node yaitu:

- server1 (192.168.0.254)

- server2 (192.168.0.252)

- server6 (192.168.0.249)

Untuk ilustrasinya digambarkan seperti di bawah ini:

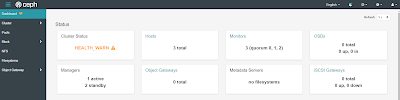

Ceph cluster ini dibangun menggunakan aplikasi ceph versi Octopus yang di install di atas ketiga server dengan sistem operasi Ubuntu 20.04. Dari ilustrasi di atas sudah terdapat 3 manager server (1 aktif 2 standby), 3 Monitor server (1 Aktif dan 2 Standby).

Rencananya saya akan menambahkan 1 server OSD ke dalam ceph cluster.

Server OSD ini berfungsi sebagai penampung data yang disimpan di dalam ceph cluster.

Posisi server OSD ini akan saya taruh di server1 terlebih dahulu.

Sehingga apabila di ilustrasikan nantinya jadi seperti ini:

dari kotak OSD, terlihat bahwa belum ada satupun OSD di dalam ceph cluster yang aktif.

Untuk memulai menambahkan server OSDnya, saya akan masuk ke dalam server1.

Setelah login ke dalam server1, saya akan lihat dulu untuk memastikan bahwa terdapat partisi terpisah dari system yang akan saya jadikan OSD di dalam ceph cluster,

saya menjalankan perintah:

hasilnya adalah sebagai berikut:

berdasarkan keluaran yang saya highlight saya akan menggunakan partisi /dev/sdb (9.1TB)

sebagai OSD. Partisi /dev/sdb belum di format dan belum memiliki filesystem,

jadi masih belum ada tabel partisinya.

Untuk memulai menambahkannya saya harus masuk dulu ke shell cephadm di server1 dengan menjalankan perintah:

hasilnya seperti ini:

hasilnya adalah sebagai berikut:

perhatikan bagian OSD yang saya highlight,

masih bernilai 0, lalu perhatikan lagi bagian yang saya highlight pada gambar di bawah ini juga:

pada bagian usage masih terlihat 0 Byte yang tersedia.

Untuk menambahkan OSD ke dalam cluster,

saya cukup menjalankan perintah:

jika berhasil, keluarannya akan terlihat seperti ini:

lalu silahkan lihat status OSD di dalam ceph dashboard, maka hasilnya seperti ini:

dari gambar di atas terlihat bahwa OSD sudah bertambah 1, untuk memastikannya saya kembali menjalankan perintah:

untuk melihat status ceph cluster dan ini hasilnya:

perhatikan pada bagian yang saya highlight terlihat juga ada 1 OSD yang sudah up,

lalu di bawahnya pada bagian usage ada 9,1TB yang tersedia.

Untuk melihat server OSD yang aktif berasal dari mana saja, saya menjalankan perintah:

maka hasilnya seperti ini:

dari sana terlihat bahwa OSD milik server1 yang telah aktif.

Sekian catatan saya terkait penambahan OSD ke dalam ceph cluster.

Sampai jumpa lagi dan silahkan tulis di kolom komentar apabila ada pertanyaan.

Comments